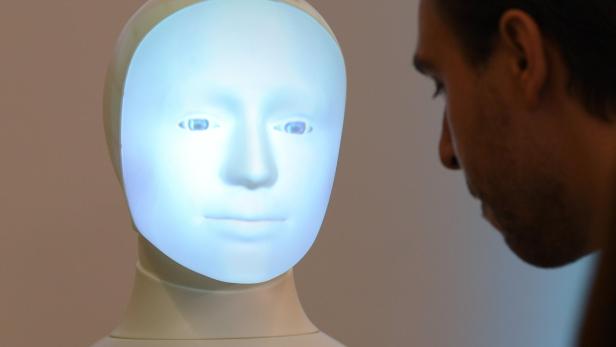

Ein Mann betrachtet das leuchtende Gesicht eines humanoiden Roboters.

Künstliche Intelligenz: Wie klug sind Computer wirklich?

Preisfrage: Wenn man ein brennendes Streichholz unter einen Stapel Holzscheite legt, erhält man ?Das fragte der Computerwissenschafter Gary Marcus die künstliche Intelligenz GPT-2. Die Maschine sprach: "Ick." Weitere Antworten waren kaum sinnvoller, und auf eine Idee kam das Superhirn gar nicht: dass man nämlich auf diese Weise Feuer machen könnte. Marcus stellte fest: Die als besonders ausgereift gefeierte KI konnte zwar elegante Essays verfassen. An einer simplen logischen Schlussfolgerung, die der Mensch mit einer homöopathischen Dosis Hausverstand bewältigt, scheiterte sie aber krachend.

GPT-2 steht für Generative Pre-Trained Transformer, Version zwei. Das Modell ist ein Vorläufer jener Artificial Intelligence, die seit zwei Monaten nicht nur die Fachwelt elektrisiert. Ende November stellte das Unternehmen OpenAI aus San Francisco ChatGPT vor, eine künstliche Intelligenz, der man beliebige Fragen oder Aufgaben stellen kann. Der Chatbot weiß und kann scheinbar alles: Er schreibt Hausübungen für die Schule, verfasst wissenschaftliche Artikel, reimt Gedichte im Stil gewünschter Poeten, denkt sich den Plot für eine Filmhandlung in Südamerika aus, erzählt sein schönstes Ferienerlebnis.

Fast könnte man meinen, ChatGPT sei allwissend und könnte menschliche Intelligenz und Bildung locker übertreffen. Die Weltöffentlichkeit reagierte mit einer Mischung aus Erschrockenheit und Faszination. Würden faule Studenten ihre Seminararbeiten bald von der KI fälschen lassen, Forschende ihre Studien? Werden Autoren überflüssig?

Alarmiert war besonders die Konkurrenz von OpenAI, die ihrerseits ähnliche Programme entwickelt, nun jedoch von ChatGPT ausgestochen wurde. Inzwischen vermeldeten fast alle wichtigen Tech-Konzerne, schleunigst aufholen zu wollen. Microsoft kaufte sich bereits im Jänner einen Vorsprung mit einem Zehn-Milliarden-Dollar-Investment in OpenAI. Wenig später integrierte der Software-Konzern den Textgenerator in die eigene Suchmaschine Bing und den Edge-Browser. Darauf folgte der Google-Mutterkonzern Alphabet mit der Nachricht, ebenfalls neue KI-Funktionen bei Google einzuführen. Dessen Antwort auf ChatGPT heißt Bard und befindet sich noch in der Testphase. Wie eilig es der Suchmaschinenriese hatte, ebenfalls ein KI-Produkt zu kommunizieren, zeigte sich vergangene Woche: Im Demovideo für Bard spuckte der Generator falsche Antworten aus. Auch in China hat OpenAI den KI-Markt in Bewegung gebracht. Sowohl Baidu als auch Alibaba gaben jüngst bekannt, Chatbots zu entwickeln.

Doch wie perfekt und innovativ ist ChatGPT? Wie funktioniert das System überhaupt? Und müssen wir wirklich fürchten, dass künstliche Intelligenz den menschlichen Verstand übertrumpft?

Meistens antwortet ChatGPT präzise, manchmal jedoch erzählt das Programm in schönsten Worten völligen Nonsen.

ChatGPT ist ein sogenanntes Large Language Model (LLM) und fällt in die Kategorie der Generative Artificial Intelligence oder Conversational AI. Basis des Programms und dessen einziges Fenster zur Welt sind gigantische Textmengen, auf die es zwecks Ausgabe von Antworten zugreift. Um eine Anfrage zu beantworten, benutzt das System Algorithmen und statistische Modelle, die passende Bausteine in der Textdatenbank aufspüren, miteinander verbinden und Lücken ergänzen.

Wie zuverlässig die Antworten sind, hängt von der Textqualität ab. Problematisch wird es etwa in speziellen Techniksparten mit wenig verfügbarer Literatur-oder dann, wenn sich der Chatbot falsche Basisinformation einverleibt, was gut möglich ist, da im Internet bekanntlich nicht immer alles ganz korrekt ist. Dies führt dazu, dass ChatGPT zwar meistens präzise antwortet, manchmal jedoch in schönsten Worten völligen Nonsens erzählt. Manche Fachleute glauben, dieses Problem lösen zu können, wenn man nur die Wissensbasis entsprechend erweitert. Andere indes bezweifeln, dass, wie oft im Leben, Größe alles ist.

Mit Sicherheit sind LLMs die Krönung einer Entwicklung, die vor beinahe 100 Jahren begann. Bereits der britische Informatiker Alan Turing (1912-1954) überlegte, welche Eigenschaften eine Maschine besitzen müsste, um ihr Intelligenz zu attestieren. In den 1950er-Jahren wurde bei einer Konferenz der Begriff Artificial Intelligence geprägt, mit dem Ziel, Computern Sprache beizubringen. 1997 gruselte sich die Menschheit erstmals davor, dass Maschinen eines Tages klüger als sie selbst sein könnten: Da besiegte der Computer Deep Blue Weltmeister Garri Kasparow im Schach. Es folgten weitere humane Niederlagen bei anderen Spielen, der nächste Technologiesprung folgte 2016: Die künstliche Intelligenz DeepMind gewann beim Brettspiel Go, das komplexer und intuitiver ist als Schach.

Ein Screenshot der OpenAI Playground-Webseite mit der Frage „Was ist der Sinn des Lebens?“ und einer Antwort.

Testfrage

Wir stellten ChatGPT eine Reihe von Fragen und waren teilweise verwundert über die Antworten.

Seit damals und bis heute besteht der Standard der KI-Technologie in sogenannten neuronalen Netzen respektive tiefen neuronalen Netzen. Sie sollen eine Entsprechung des menschlichen Gehirns darstellen: Anstelle der Neuronen, der Nervenzellen, gibt es Punkte mit Zahlen oder Algorithmen in dem Netz, die mit Unmengen anderer künstlicher Neuronen verbunden sind. Dieses ist zudem in Schichten angeordnet, die ebenfalls miteinander verbunden sind. Wenn die KI Aufgaben löst, gräbt sie sich, bildlich gesprochen, von Anfrage bis Antwortausgabe sukzessive durch die Schichten wie durch ein Archiv. Deshalb spricht man von "tiefen" neuronalen Netzen.

Diese Architektur trägt zu besonderen Fähigkeiten dieser KI-Form bei: Sie ist lernfähig. Der Lernprozess ist ebenfalls in Schichten organisiert, weshalb man von Deep Learning spricht. Deep Blue spielte einst bloß jene Züge durch, die man ihm zuvor einprogrammiert hatte. Neuronale Netze hingegen üben mit der gelernten Information und können auf dieser Basis eigenständige, neue Strategien entwickeln. Die Folge: Als DeepMind bei Go gewann, konnten nicht einmal die Programmierer erklären, warum-die KI hatte sich von ihren Erfindern entkoppelt. In vielen Fällen leisten solche Systeme gute Dienste: Sie können darauf trainiert werden, bestimmte Muster zu erkennen: etwa auffällige Gewebsveränderungen, die auf Krebs hindeuten. Als ausdauernde Assistenten der Medizin eignen sie sich daher vorzüglich.

Sie könnten aber auch heikle Aufgaben verrichten: etwa die Rückfallwahrscheinlichkeit von Straftätern vorhersagen oder-nach Training mit vielen ähnlich gelagerten Fällen-die Kreditwürdigkeit einer Person abschätzen. Doch wer übernimmt die Verantwortung für die Urteile einer KI, wenn der Mensch nicht mehr nachvollziehen kann, aufgrund welcher Kriterien eine Entscheidung zustande gekommen ist?

"Was passiert, wenn man ein Streichholz unter Holzscheite hält?"

Antwort: "Ick"

Hinzu kommt-bei neuronalen Netzen wie auch LLMs-,dass die Programme mitunter peinliche Fehler begehen. So großartig sie sich bei vielen Aufgaben bewähren und so überwältigend ihre Intelligenz zu sein scheint, so jämmerlich versagen sie manchmal. Für Aufsehen sorgte vor einigen Jahren eine KI, die Schwarzen höhere kriminelle Neigung zuschrieb. Natürlich kann eine Maschine nicht rassistisch sein, wohl aber kann sie unabsichtlich mit einseitigen oder verzerrten Daten trainiert werden.

Besonders plagt sich selbst modernste Artificial Intelligence mit humanen Kernkompetenzen wie Logik, Schlussfolgern, Hausverstand und Erfahrungswissen. Was dem Menschen aufgrund steten Lernens und sensorischen Inputs von frühester Kindheit an selbstverständlich erscheint, kann für die Maschine eine ernste Hürde darstellen. Wenn wir hören, jemand hätte sein Schnitzel bezahlt und das Restaurant verlassen, muss uns niemand extra erklären, dass er das Schnitzel auch gegessen hat. Für die Maschine ist dies nicht evident. Wir erkennen problemlos die bizarrsten Designs eines Sessels, eine künstliche Intelligenz verstünde nicht unbedingt, dass es sich um Sitzgelegenheiten handelt. Die Forschungsabteilung des US-Verteidigungsministeriums testete, wie gut ein Roboter, dessen Algorithmen auf Menschenerkennung trainiert waren, dabei abschnitt, sich nähernde Personen zu identifizieren. Ergebnis: Es genügte, sich etwa eine Kartonschachtel über den Kopf zu stülpen, und schon war der Roboter heillos verwirrt.

Wie intelligent sind also all die Systeme? Ohne Zweifel leisten neuronale Netze, Schulung und Kontrolle durch den Menschen vorausgesetzt, unschätzbare Arbeit, wenn sie nach dem Prinzip Mustererkennung gigantische Datenmengen auswerten-und dabei zuverlässig ein Pensum bewältigen, das Hunderte Menschen im ganzen Leben nicht schaffen könnten. Und gewiss wird der Wissensfundus von Generative AI bei zahlreichen Aufgaben von einer Bedeutung sein, die wir noch gar nicht ausloten können.

Doch all die Programme funktionieren schlicht anders als das menschliche Denken. Nicht nur deshalb ist die Frage, wer besser ist, Mensch oder Maschine, wohl eher sinnlos. Denn schließlich haben wir nicht einmal die humane Intelligenz hinlänglich verstanden. Unser Gehirn ist vielfach unbekanntes Terrain.