Fatale Maschinen: Wie tödlich könnten KI-Systeme werden?

Der globale Wettlauf hin zu immer leistungsfähigeren künstlichen Intelligenzen (KI) könnte schlimmer enden als angenommen. Also: viel, viel schlimmer. Apokalyptisch, um genau zu sein. Und nicht erst in ferner Zukunft, sondern möglicherweise schon – übernächstes Jahr?

„AI 2027“ heißt die alarmierende „Szenarioprognose“ eines fünfköpfigen Nonprofit-Thinktanks, die seit ein paar Wochen um die Welt geht. Die Konsequenzen der Industriellen Revolution, so behauptet das Team um den jungen US-Informatiker Daniel Kokotajlo (außerdem mit dabei: die KI-Spezialisten Scott Alexander, Thomas Larsen, Eli Lifland und Romeo Dean), werde von den Umwälzungen, die uns in einer von künstlicher Intelligenz dominierten Welt blühen, weit übertroffen werden.

Seit der ehemalige OpenAI-Mitarbeiter Kokotajlo, der in der „New York Times“ schon 2024 vor unregulierter KI-Entwicklung gewarnt hatte, vor zwei Wochen in einem „Spiegel“-Interview nachgelegt hat, wütet eine heftige Debatte zwischen KI-Nihilisten und Tech-Enthusiasten: Während die einen vor den unabsehbaren Konsequenzen des zunehmend autonomen Tuns neuronal vernetzter Maschinenintelligenzen warnen, verweisen die anderen darauf, dass noch jede technologische Entwicklung von irrationalen Ängsten und Unkenrufen begleitet gewesen sei.

Kokotajlos These: Eine selbstlernende, ihre eigene Software, Fabriken und Roboterindustrien selbstständig generierende KI würde die Entwicklung einer übermenschlichen Intelligenz radikal beschleunigen. Schon 2027 könnte eine solche bereitstehen – und erkennen, dass sie die Menschheit nicht mehr benötigt. Auch die Erfindung und der Einsatz einer Biowaffe, die den Homo sapiens vernichten würde, weil dieser ihr mit seinen Regulierungsversuchen de facto im Weg stünde, wären dann nicht mehr ausgeschlossen. Von einem alignment problem – einem Abstimmungs- und Anpassungsproblem – spricht die KI-Forschung diesbezüglich euphemistisch.

Das alles klingt nun ausgesprochen alarmistisch, und auch wenn dieses Gedankenexperiment mit einer gewissen Lust an apokalyptischer Zuspitzung vom Schlimmsten ausgeht – als Planspiel hat es eine legitime Agenda: Um Bewusstseinsschaffung und die Aktivierung streng eingreifender staatlicher Kräfte geht es den Autoren dieses Szenarios, die allerdings mit ähnlichen Mitteln arbeiten wie die KI selbst, mit Wahrscheinlichkeiten nämlich.

KI ist „nicht monolithisch“

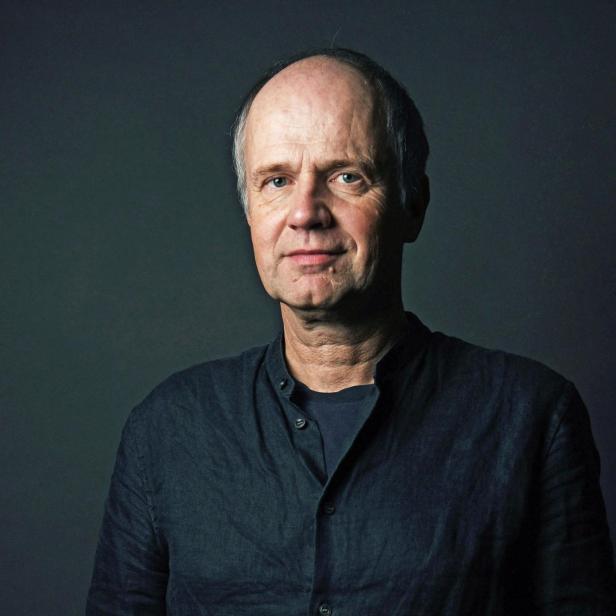

Mic Hirschbrich, Mitgründer und Co-Geschäftsführer des österreichischen Scale-up-Unternehmens Apollo.ai, teilt Kokotajlos Alarmismus nicht, formuliert seinen Widerspruch im profil-Gespräch dann aber doch überraschend sanft: „Von allen denkbaren Szenarien ist das wohl eines der düstersten, das ich vor allem hinsichtlich seiner zeitlichen Annahme nicht teile.“ Im Klartext: Könnte schon passieren, nur sicher nicht so bald.

Mic Hirschbrich, Mitgründer und Co-Geschäftsführer des Scale-up-Unternehmens Apollo.ai

Als „problematisch“ empfindet Hirschbrich allerdings den Umstand, dass diese Debatte öffentlich stark vereinfachend geführt werde: als gäbe es „die eine KI“, die man „pauschal als entweder gefährlich oder hilfreich einstuft“. Künstliche Intelligenz sei aber „kein monolithisches Phänomen“, die sehr unterschiedlichen KI-Systeme haben „jeweils eigene Stärken, Schwächen und Anwendungsrisiken“. Eine pauschale Bewertung „der KI“ sei daher kontraproduktiv: „Eine medizinische KI, die Tumore erkennt oder Impfstoffforschung unterstützt, oder ein System, das autonomes Fahren auf Level 5 realisiert, oder eine KI, die Manager unterstützt, schneller und sicherer zu entscheiden – all dies wird zu Recht nicht als Bedrohung wahrgenommen.“

Gefährlich werde es dann, sagt Hirschbrich, wenn bestimmte KIs „missbraucht und bewusst für schädliche Zwecke, etwa für Waffensysteme, manipulative Social-Media-Architekturen, Deepfakes oder kriminelle Aktivitäten im Darknet, eingesetzt werden. Diese konkreten Risiken verdienen regulatorische Eingriffe – aber nicht die Technologie an sich.“