Die KI spürt verdächtiges Verhalten auf, und dann kommen echte Ermittler ins Spiel?

Lacroix

Genau. Dann kann man etwas aufdecken – oder auch nicht, weil die KI falschliegt und noch lernen muss. Ins Spiel kommt sie auch bei beschlagnahmten Festplatten und Computern. Die KI liefert in wenigen Stunden Datenanalysen, für die wir früher Monate gebraucht haben. Zeit spielt eine große Rolle, denn diese Leute reorganisieren sich in der Regel sehr schnell, vernichten alles und sind über alle Berge. Dann haben wir sie verloren.

Hilft die KI auch dabei, Polizisten traumatisierende Ermittlungen zu erleichtern, etwa bei Fotos und Videos, die missbräuchliche Inhalte zeigen?

Lacroix

Ja, wir arbeiten mit Modellen, die bestimmte Inhalte von Fotos und Videos für Ermittlungen neutralisieren. AWS (Amazon Web Service, Dienste für Cloud-Computing, Anm.) bietet brillante Werkzeuge an: Man lädt ein Foto hoch, und es zeigt an, wo es gemacht wurde.

Die Software hilft auch dabei, aus Videos Rückschlüsse auf den Drehort herzuleiten.

Lacroix

AWS wäre nicht froh, wenn wir Millionen pädopornografischer Bilder hochladen würden, dabei wäre das sehr hilfreich – Amazon hat Werkzeuge zur Kontexterkennung entwickelt, die wir nie haben werden. Also neutralisieren wir bestimmte Inhalte von Fotos und Videos und machen dann die Analyse. Generell aber nutzt Interpol keine Clouds. Nicht, weil sie nicht sicher sind, sondern weil wir neutral bleiben müssen – und die Clouds amerikanisch, chinesisch oder europäisch sind. Sobald ich etwas in eine US-Cloud hochlade, sieht es sich die NSA an. Die anderen Länder wollen das nicht, und wir müssen als Organisation das Vertrauen unserer Mitgliedstaaten halten.

Wie stellt Interpol sicher, dass die KI ihre Analysen nicht auf rassistischen Stereotypen aufbaut?

Lacroix

Jedes Datenset ist befangen. Die kognitive Voreingenommenheit ist im Menschen tief verwurzelt, und sie ist sehr hilfreich. Sie erlaubt uns, rasch Urteile zu fällen.

Voreingenommenheit hilft auch in der Einordnung, ob etwas gefährlich ist, zu heiß oder giftig …

Lacroix

Ja, und bei Datensets ist es ebenso. Der Kontext der Daten bestimmt ihren Wert und ihren Zweck. Ich arbeite mit 196 Mitgliedstaaten, ich kenne Voreingenommenheit. Menschliche digitale Fußabdrücke sind sehr ungleich. Kommt jemand aus San Francisco oder aus einem Vorort Lesothos? Modelle, die auf dem digitalen Fußabdruck basieren, sind immer voreingenommen. Deswegen glauben wir nicht an globale Modelle, sondern arbeiten kontextabhängig.

Ist die KI also rassistisch?

Lacroix

Kommt darauf an, mit welchen Informationen man sie füttert. Um es deutlich zu formulieren: Kommt Scheiße rein, wird Scheiße rauskommen. Das hat man bei Elon Musks KI gesehen.

Grok, die KI auf Musks Plattform „X“, gab antisemitische und rassistische Tiraden ab, nachdem Musk daran geschraubt hatte.

Lacroix

Sie haben irgendwelche Richtlinien entfernt. In den USA geschieht das immer wieder, in Europa geht das nicht. Wenn man sie entsprechend trainiert, kann die KI auch eine Neuauflage von Hitlers „Mein Kampf“ schreiben. Sie ist ein Werkzeug. Mit einem Hammer kann man einen Nagel einschlagen oder jemandem den Schädelknochen brechen.

Wer hält Schurken davon ab, KI gegen uns zu nutzen?

Lacroix

Die Leute, die wir jagen, haben Ingenieure und Programmierer aus den besten Schulen, die täglich Verbrechen begehen. Für Geld, für Macht. Die KI muss kontrolliert werden, reguliert und überwacht, aber dafür brauchen wir einen globalen Konsens. Heute sind die Regeln von Kontinent zu Kontinent unterschiedlich. Jede Regierung sollte sich an dieser Arbeit beteiligen.

Der ehemalige OpenAI-Mitarbeiter Daniel Kokotajlo warnt, KI könnte bald die Menschheit auslöschen oder ihr zumindest schwer schaden. Er schätzt diese Wahrscheinlichkeit auf 70 Prozent. Ist die Gefahr wirklich so groß?

Lacroix

Wir sagten dasselbe über Atomwaffen. Für die einen waren sie der Schlüssel zum Frieden, die anderen warnten, dass sie die Menschheit vernichten könnten – zu Recht, denn wir hatten genug, um die Welt Hunderte Male zu zerstören. Zum Glück ist das nicht passiert. Aber ja: KI kann eine Massenvernichtungswaffe sein.

Kokotajlo befürchtet, dass die KI von selbst zur Waffe werden könnte, ohne menschliche Befehle.

Lacroix

Sie sollten mit einem U-Boot-Kapitän sprechen. Als ich jung war, arbeitete ich mit dem Militär zusammen. Auf den Booten, auf denen ich mitfuhr, suchten sie immer nach jemandem, der am Ende den roten Knopf drücken würde. Niemand will das machen. Das System könnte es auch allein, aber man will die menschliche Kontrolle bewahren. Ein Torpedo kann problemlos Ziele ausfindig machen und zuschlagen, doch das wollen sie nicht. Sie haben Angst, dass der Torpedo umdreht und sich gegen das eigene Schiff wendet. Sicherheitsrichtlinien sollten immer Teil der KI-Debatte sein.

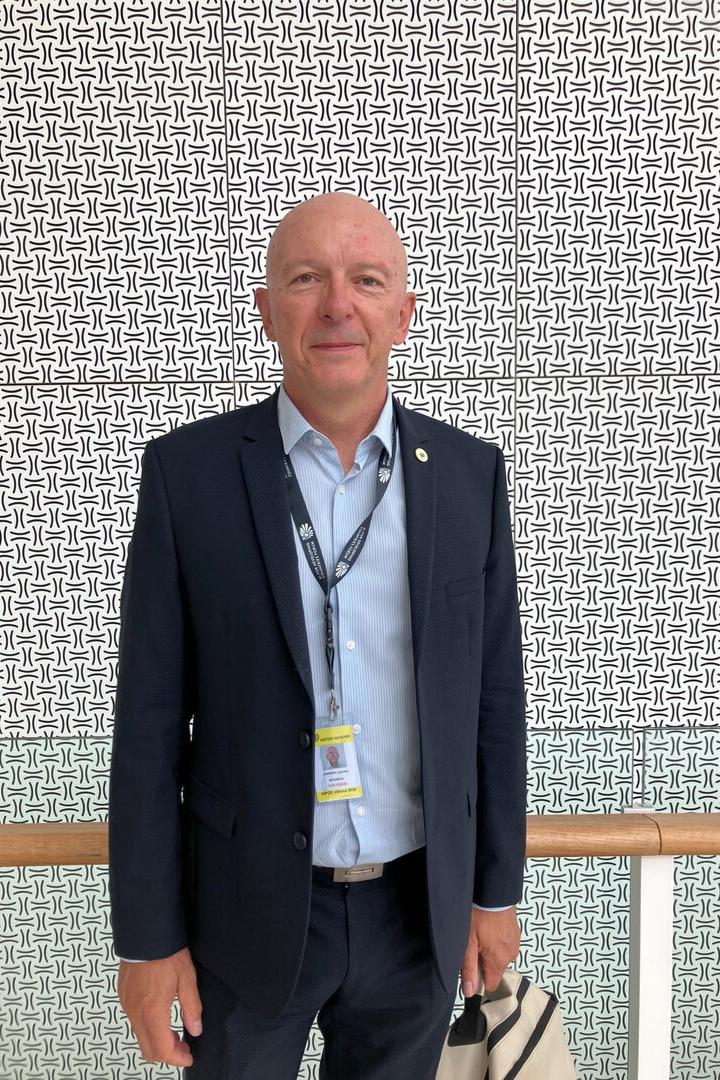

Laurent Lacroix

leitet die Datenabteilung der internationalen kriminalpolizeilichen Organisation Interpol mit Sitz in Lyon. Aufgabe der weltgrößten Polizeiorganisation ist es, nationale Behörden bei der Bekämpfung und Verhütung von Verbrechen zu unterstützen. Dabei nutzt Interpol auch künstliche Intelligenz. Lacroix war vergangene Woche im Rahmen der Konferenz „AI For Developing Countries“ (AIFOD) zu Gast in Wien.