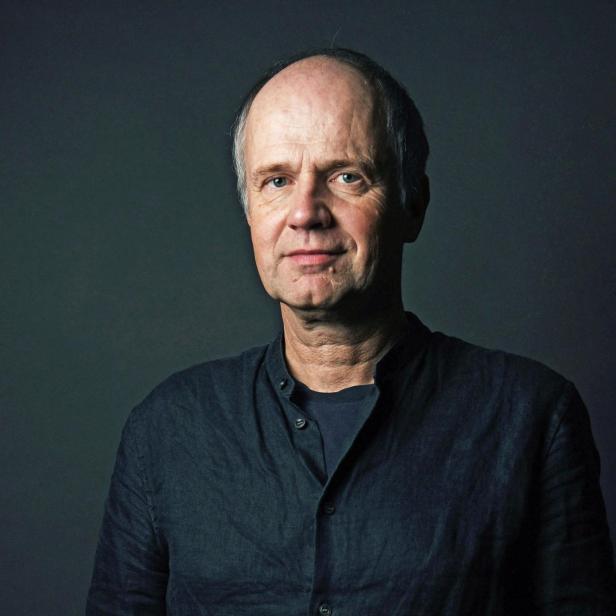

Sarah Spiekermann, 51, ist Wirtschaftsinformatikerin, Buchautorin und Vortragende; sie lehrt an der Wiener WU.

Sind wir den Maschinen ausgeliefert? KI-Expertin Sarah Spiekermann im Interview

Als Informatikerin ist die deutsch-österreichische Wissenschafterin eine rare Erscheinung, denn sie begegnet den Computersystemen, an denen sie arbeitet, mit ausgeprägter Skepsis. Fortschritt brauche Weisheit und Mut, sagt sie: Maschinen fehle beides.

An Wiens Wirtschaftsuniversität leitet Sarah Spiekermann, geboren in Düsseldorf 1973, seit 2009 das Institut für Wirtschaftsinformatik & Gesellschaft. Sie ist als Lehrende, als Autorin und Forscherin vielfältig aktiv, als Referentin und Keynote-Sprecherin weltweit gebucht. Digitale Ethik ist ihr Spezialgebiet, Value-based Engineering – eine auf humanistische Werte zielende Technologie – ihr Zugang. Sie hat zahllose Artikel und Forschungsarbeiten zu den sozial-ethischen Implikationen von IT-Systemen veröffentlicht, US- und EU-Datenschutzbestimmungen mitverfasst, die EU-Kommission und die OECD beraten. In ihrem Buch „Digitale Ethik“ (Droemer Verlag, 2019) hat sie ein „Wertesystem für das 21. Jahrhundert“, in „Value-Based Engineering" eine Anleitung zum Aufbau ethischer Technologie für die Menschheit entwickelt. Im „Philosophischen Handbuch Künstliche Intelligenz“ (Springer) hat sie zuletzt einen Betrag zu Digitaler Ethik verfasst.

Eine Gruppe von KI-Experten hat unlängst vor der drohenden Apokalypse durch eine potenziell autonom agierende, übermenschliche künstliche Intelligenz gewarnt. Sind diese Leute im Besitz eines geheimen Wissens?

Sarah Spiekermann

Wir tendieren dazu, Informatikern, die ganz nah an den vielgenutzten Large-Language-Modellen arbeiten, außergewöhnliche Kompetenz und immenses Wissen zuzuschreiben. Auch der Nobelpreisträger Geoffrey Hinton hat eindringlich vor einer sich selbstständig machenden KI gewarnt. Wir trauen solchen Menschen, etwa auch dem OpenAI-Chef Sam Altman und dem Unternehmer Elon Musk, eine tiefere Einsicht in diese Systeme zu, weil sie Zugang zu Dingen haben, die keiner von uns nachvollziehen kann.

Sie bezweifeln deren Kenntnisstand?

Spiekermann

Es hat uns leider noch keiner dieser Gurus erklärt, was in ihren Daten konkret darauf hinweist, dass sich demnächst eine Superintelligenz entwickeln könnte. Wenn uns einer dieser großen Warner das erklärt oder seine Behauptungen begründet hätte, wäre meine Skepsis vielleicht geringer. Aber wenn ich mich mit Kollegen aus der Informatik unterhalte, die verschiedenste KI-Formen bauen, Large-Language-Modelle betreiben und weiterentwickeln, dann teilt kaum jemand die Idee, dass sich tote Materie selbstständig machen und der Sprung vom Toten zum Lebendigen vollzogen werden könnte, dass wir es plötzlich mit einem System zu tun haben sollten, dem man eigenes Bewusstsein zuschreiben kann.

Woher kommt dann dieser Alarmismus?

Spiekermann

Abgesehen von jenen, die schlichte ökonomische Interessen oder persönliche Aufmerksamkeits- und Marketing-Anliegen verfolgen: All die Warner, inklusive Geoffrey Hinton, sitzen einer wissenschaftlich eigentlich bereits teilweise widerlegten Theory of Mind, einer bestimmten Mentaltheorie auf. Denn es gab in den Kognitionswissenschaften vor 2010 die starke, aber umstrittene Idee, dass unser Gehirn wie ein neuronales Netzwerk funktioniere – und dass wir im Prinzip alles Existierende bloß konstruieren. Das passt unheimlich gut in die Informatik. Aber Leben, Denken und Verstehen sind viel komplexer und wissenschaftlich noch immer kaum auf den Punkt zu bringen. Wir haben es hier also mit Lebensphänomenen zu tun, über die unsere Wissenschaft nur spekulieren kann. Aber viele prominente Informatiker schreiben ihren Maschinen weiterhin leichtsinnig Begriffe wie „denken“, „betrügen“, „überlisten“ zu. Und das ist hochproblematisch, weil es diesen Leuten an Wissen und Demut mangelt; es ist ein Akt der Hybris und auch eine Unverschämtheit, dass uns intelligente Menschen derart verwirren – und dabei zugleich die offensichtlichen Fehleranfälligkeiten und Probleme der heutigen IT-Welt verschleiern, die öffentliche Debatte ablenken von dem, was wirklich relevant ist.

Man nennt die oft absurden Fehlleistungen der KI auch „Halluzinationen“ – erneut vermenschlichend. Offensichtlich sind diese Systeme darauf programmiert, alle Informationslücken so zu füllen, dass ihre Antworten trotzdem halbwegs souverän erscheinen.

Spiekermann

Das sind Wahrscheinlichkeitsmaschinen, die nur Satz- und Wortbestandteile nach Möglichkeitsmustern aneinanderreihen. Diese Large-Language-Modelle können eigentlich nur eines: assoziieren. Sie sind nicht in der Lage zu denken. Wenn ich an der Universität einen Studenten vor mir habe, der nicht viel weiß, in der Prüfung aber sehr eloquent agiert, das Bullshitten und Assoziieren perfekt beherrscht, kann ich das durchschauen. Auch diese Maschinen sind Bluffer. Sie können aber gar nichts wissen. Sie assoziieren sich lediglich durch den unglaublich reichen Menschheitsschatz an Wissen, mit dem sie trainiert werden. Wir haben unsere Poesie, unsere gesamte Wissenschaft, alle unsere Bücher, sämtliche Enzyklopädien, alles, was die Menschheit geschrieben hat, dazu benutzt, um diese KIs zu trainieren. Deren Assoziationstalent beeindruckt uns dann so sehr, dass wir das Gefühl kriegen, wir hätten Leben vor uns. Aber das stimmt nicht. Es sind Korrelations- und Wahrscheinlichkeitsmaschinen.

KI-Systeme stellen auch Zusammenhänge her, die die Menschheitsgeschichte umschreiben könnten.

Spiekermann

Ja, das ist das große Versprechen: dass die KI Dinge erkennen kann, die wir alle nicht gesehen haben – und zu denen wir dann weiterführende wissenschaftliche Untersuchungen anstellen müssen. Das kann aber nur der Mensch. Und natürlich halten die KIs uns auch einen Spiegel vor. Wenn der Chatbot eine Benutzerin mit „Sehr geehrtes junges Fräulein“ anspricht, weil er auch Kommunikations-Patterns der Vergangenheit benutzt, kann man das amüsant finden, es ist aber für viele Feministinnen gar nicht lustig. Wir sind durch die Maschinen konfrontiert mit historischen Stereotypen, mit eigenen Vorurteilen. Und wir sind beeindruckt, weil uns komplexe Zusammenhänge in zehn Sekunden perfekt erklärt werden. Dieses praktische Wissen ist eine Hilfe. Aber Intelligenz im aristotelischen, im klassischen Sinne ist es nicht.

Intelligenz ist ja vor allem auch: aktuell klug zu handeln.

Spiekermann

Ja, die KI fährt aber, wie Marshall McLuhan sagen würde, immer mit Blick in den Rückspiegel. Was den Menschen auszeichnet, ist seine Fähigkeit, die Zukunft erahnen zu können. Eine Intuition zu haben für das, was als Nächstes relevant sein könnte – oft auch auf Basis von nicht einfach artikulierbaren Prioritäten. Das ist es, was die Menschheit so klug macht.

Auch er schürt die Angst vor KI-Superintelligenzen: Sam Altman, Gründer des ChatGPT-herstellenden Unternehmens OpenAI

Auch Sam Altman, CEO des Software-Unternehmens OpenAI, meinte unlängst, dass KI-Modelle außer Kontrolle geraten könnten. An diesem Science-Fiction-Spiel beteiligen sich sogar die, die ein Interesse daran haben müssten, dass die Menschheit ihre Instrumente angstlos annimmt. Trotzdem scheinen sie Lust daran zu haben, Panik zu verbreiten. Warum?

Spiekermann

Any publicity is good publicity. Es gibt allerdings tatsächlich hier und jetzt schon apokalyptische Entwicklungen. Sie sind an der Universität angekommen. Ich habe unlängst mündliche Prüfungen abgehalten: Von 40 Studierenden konnten 39 eine einfache Frage nicht beantworten. Sie alle haben sich, obwohl ich es explizit verboten hatte, mit KI vorbereitet und mir das Blaue vom Himmel erzählt. Und als ich ihnen eine konkrete Frage zu dem Textbuch stellte, mit dem sie hätten lernen sollen, waren sie sogar über den Inhalt meiner Frage erstaunt. Und das Schlimme ist: Ich kann ihnen nicht einmal nachweisen, dass sie KI zur Vorbereitung benutzt haben. Wir können den Studierenden die KI ohne strenge Verbote und Sanktionen seitens der Universitätsleitung oder sogar des Gesetzgebers nicht mehr entziehen. Wir verplempern unsere Steuergelder in Schulen und Universitäten, an denen die Kinder, die Jugendlichen und Studierenden nichts mehr lernen, weil sie sich das Denken von der KI abnehmen lassen und keine eigene Sprachfähigkeit, kein eigenes Gedächtnis mehr entwickeln. Und das Allerschlimmste ist, dass sehr viele Kollegen dies bagatellisieren und sagen: Dann bringen wir den jungen Menschen doch das Prompten bei! Und sie verstehen nicht, dass mit „Bildung“ unserer menschlichen Gehirne und dem Ringen um eigenes Wissen auch die Entwicklung des Menschen zu einem mündigen, demokratischen Bürger wegbricht. Das ist in der Tat apokalyptisch. Immer mehr Leute werden abhängig von ihren KIs, entwickeln eine persönliche Beziehung zu den Chatbots, die weit über Social-Media-Sucht hinausgeht.

Wird dabei der Wunsch nach Kommunikation mit anderen Menschen immer schwächer? Werden wir gerne Romane lesen, die von KIs geschrieben wurden? Mir würde der geistige Austausch mit einem Menschen am anderen Ende eines Kunstwerks fehlen. Oder ist das schon eine konservative Position?

Spiekermann

Nein, Sie treffen das Gefühl des Lehrers, der keine Lust hat, KI-Auswertungen zu benoten, und das Gefühl des Schauspielers, der nicht möchte, dass die Drehbücher, nach denen er spielen soll, von einer KI verfasst wurden. Verlage stehen vor der Herausforderung, wie sie mit KI-geschriebenen Büchern umgehen, die ihnen vorgelegt werden. Weil es dann ja nicht mehr authentisches Denken ist. Unser bisheriges Effizienz- und Produktivitätsdenken ist der perfekte Nährboden für die KI, weil sie nur in einer Gesellschaft gedeihen kann, in der Effizienz und Zeit, Verfügbarkeit und Quantität als die höchsten Werte gelten; in diesem Milieu kann künstliche Intelligenz florieren.

Ist es nicht denkbar, dass es sehr bald technologische Möglichkeiten geben wird, KI-generierte Werke als solche zu erkennen? Könnten wir selbst ein Sensorium dafür entwickeln, ob und wann wir es mit KI zu tun haben?

Spiekermann

Bei den technischen Möglichkeiten der KI-Erkennung ist es ein Kopf-an-Kopf-Rennen – KIs sollen KIs erkennen lernen. Es gibt bereits eine Kennzeichnungspflicht von KI-Systemen. Aber im Allgemeinen könnte es dennoch schwer werden für uns Menschen, KI-Kommunikation mittelfristig von menschlicher Kommunikation gut zu unterscheiden. Zumindest so lange wir es zulassen, dass unser tägliches Leben mit diesen Maschinen uns prägt. Wenn wir nur noch von solchen Maschinen lernen, wenn wir mehr Zeit mit KIs verbringen als mit Menschen, wie sollen wir dann hinterher noch unterscheiden können, ob etwas vom Menschen kommt? Und dann ist da noch das Problem der Wahrheit: Wenn heute in Verlagen die Devise ausgegeben wird, dass KI-verfasste Bücher nicht akzeptiert werden, dann werden diese vermutlich in dieselben Probleme laufen wie ich mit meinen Studierenden, die mich direkt anlügen. Wenn wir nicht in der Lage sind, moralisch anständiges Verhalten zu rekultivieren, sind wir diesen Maschinen ausgeliefert.

Wird die Mensch-Maschinen-Kooperation nicht schon überall praktiziert? Und war nicht eine intensive Google-Recherche vor zehn Jahren streng genommen auch schon eine Verzerrung der „eigenen“ Leistung?